주요 키워드

로지스틱 회귀

다중 분류

시그모이드 함수

소프트맥스 함수

04-1 로지스틱 회귀

다중분류란

타겟 데이터에 2개 이상의 클래스가 포함된 문제이다.

예를 들어, 데이터(ex 사진, csv)를 보고 이게 어떤 클래스인지 - 사진 보고 고양이인지, 강아지인지, 소인지, 돼지인지 구분하는 하지만 구분하는 클래스 (동물의 수)가 2개 이상이면 다중분류라고 한다.

로지스틱 회귀란

말은 회귀지만 정작 하는건 분류 모델이다.

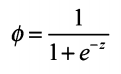

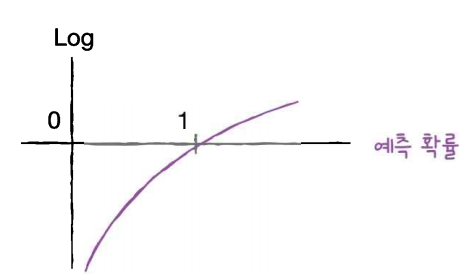

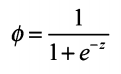

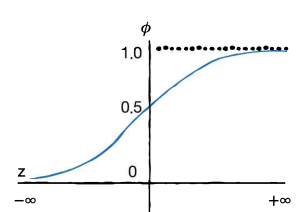

확률이라서 0~1사이의 값을 가진다. 이 때 사용하는 것이 시그모이드 함수(로지스틱 함수 or 로짓)이다.

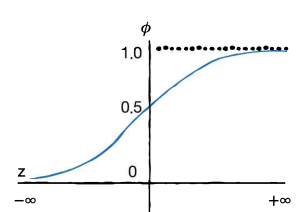

시그모이드 함수

특정 값을 넣으면 이런 그래프를 그리게 된다. 결국 0~1사이값.

소프트맥스 함수란

이진 분류 = 시그모이드

다중 분류 = 소프트맥스

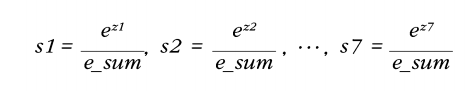

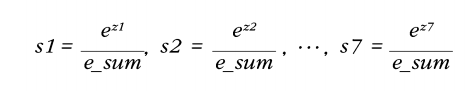

다중 분류의 선형방정식에서 z값을 클래스의 개수만큼 가지고 있고 sum(zs) 을 분모로 가져가고 si를 분자로 가져간다.

나중에 신경망에 대해서 배울 때 자세하게 나온다.

K-최근접 이웃 모델로 확률을 출력할 수 있지만 비슷한 확률로 나온다 매번 같게 왜냐면 클래스의 수가 정해져있으니까

그럴 때 좀 있어보이게 클래스가 2개면 이진분류로 가는거고 더 많으면 다중분류로 로지스틱, 소프트맥스 사용해주면 좀 더 멋있는 확률을 구할 수 있다.

하지만 이런 멋진 로지스틱이나 소프트맥스에도 단점은 있다. 0~1 사이의 값, 예를 들어 input으로 엄청 큰 값이 들어온다면 1에 무한히 가까워 질 것이다. 그렇다면 확률로 1은 무엇인가 100%다. 과학은 100%를 좋아하지 않는다. 이 세상에 100%로 일어나는 일이 있는가? 찾아보기 힘들 것이다.

확인문제

1. 2

2. 1

3. 3

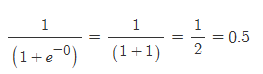

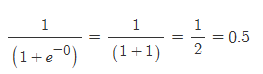

3번 z에 0이 들어오면 결과는 0.5가 나온다.

04-2 확률적 경사 하강법(SGD)

주요 키워드:

확률적 경사 하강법

손실 함수

에포크

확률적 경사 하강법

훈련 세트를 사용해 모델을 훈련할 때 전체 샘플을 사용하지 않고 딱 하나의 샘플을 훈련 세트에서 랜덤하게 골라 가장 가파른 길을 찾는다. = 훈련 세트에서 랜덤하게 하나의 샘플을 고르는 것

에포크

훈련 세트 한 세트를 수행하는걸 에포크라고한다.

훈련세트에서 하나의 샘플 말고 여러개 샘플을 뽑아내면 미니배치 경사 하강법이다.

손실함수는 알고리즘이 얼마나 엉망인지를 알려준다. 그럼 작을 수록 좋겠네?

하지만 최솟값은 알지 못한다. (global minima를 알지 못하여 local minima를 찾아간다.)

cost function = 손실함수 뭐 비슷하다.

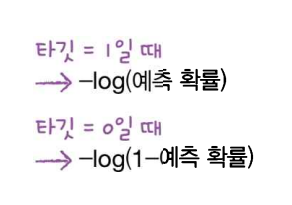

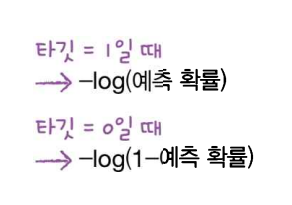

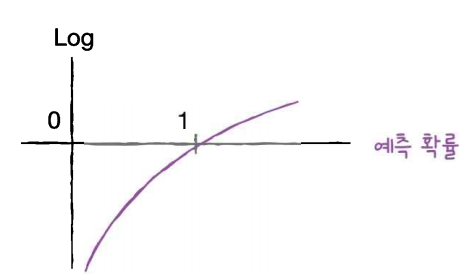

로지스틱 함수처럼 [0, 1]로 결과가 나오는 경우에 사용할 수 있다. 다음과 같이 함수를 정의했다. target=1일 때에는 로그를 취해서 -를 붙여준 손실값을, target=0일 때에는 target=1인 것처럼 변환하여 손실값을 구해준다.

말로하면 엄청 어려워보이지만 사진으로 보면 아 뭐야 싶다

이 손실함수를 로지스틱 손실함수라고 부른다 = 이진 크로스엔트로피 함수

다중 분류에서는 크로스엔트로피 함수라고 부른다. / 회귀에서는 mse사용

에포크와 과대/과소적합

에포크 횟수가 적으면 모델이 훈련 세트를 덜 학습한다. 산을 다 내려오지 못하고 훈련을 마친다.

반대로 횟수가 많으면 모델이 훈련 세트를 너무 많이 학습해서 과대적합이다.

그러면 과대적합이 되기 전에 훈련을 종료 = 조기종료 시키면 된다.

확인문제

1. 4

2. 3

실습 코드

'AI > AID' 카테고리의 다른 글

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 06 (0) | 2024.11.07 |

|---|---|

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 05 (1) | 2024.11.05 |

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 03 (7) | 2024.10.04 |

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 02 (2) | 2024.10.04 |

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 01 (7) | 2024.09.27 |

주요 키워드

로지스틱 회귀

다중 분류

시그모이드 함수

소프트맥스 함수

04-1 로지스틱 회귀

다중분류란

타겟 데이터에 2개 이상의 클래스가 포함된 문제이다.

예를 들어, 데이터(ex 사진, csv)를 보고 이게 어떤 클래스인지 - 사진 보고 고양이인지, 강아지인지, 소인지, 돼지인지 구분하는 하지만 구분하는 클래스 (동물의 수)가 2개 이상이면 다중분류라고 한다.

로지스틱 회귀란

말은 회귀지만 정작 하는건 분류 모델이다.

확률이라서 0~1사이의 값을 가진다. 이 때 사용하는 것이 시그모이드 함수(로지스틱 함수 or 로짓)이다.

시그모이드 함수

특정 값을 넣으면 이런 그래프를 그리게 된다. 결국 0~1사이값.

소프트맥스 함수란

이진 분류 = 시그모이드

다중 분류 = 소프트맥스

다중 분류의 선형방정식에서 z값을 클래스의 개수만큼 가지고 있고 sum(zs) 을 분모로 가져가고 si를 분자로 가져간다.

나중에 신경망에 대해서 배울 때 자세하게 나온다.

K-최근접 이웃 모델로 확률을 출력할 수 있지만 비슷한 확률로 나온다 매번 같게 왜냐면 클래스의 수가 정해져있으니까

그럴 때 좀 있어보이게 클래스가 2개면 이진분류로 가는거고 더 많으면 다중분류로 로지스틱, 소프트맥스 사용해주면 좀 더 멋있는 확률을 구할 수 있다.

하지만 이런 멋진 로지스틱이나 소프트맥스에도 단점은 있다. 0~1 사이의 값, 예를 들어 input으로 엄청 큰 값이 들어온다면 1에 무한히 가까워 질 것이다. 그렇다면 확률로 1은 무엇인가 100%다. 과학은 100%를 좋아하지 않는다. 이 세상에 100%로 일어나는 일이 있는가? 찾아보기 힘들 것이다.

확인문제

1. 2

2. 1

3. 3

3번 z에 0이 들어오면 결과는 0.5가 나온다.

04-2 확률적 경사 하강법(SGD)

주요 키워드:

확률적 경사 하강법

손실 함수

에포크

확률적 경사 하강법

훈련 세트를 사용해 모델을 훈련할 때 전체 샘플을 사용하지 않고 딱 하나의 샘플을 훈련 세트에서 랜덤하게 골라 가장 가파른 길을 찾는다. = 훈련 세트에서 랜덤하게 하나의 샘플을 고르는 것

에포크

훈련 세트 한 세트를 수행하는걸 에포크라고한다.

훈련세트에서 하나의 샘플 말고 여러개 샘플을 뽑아내면 미니배치 경사 하강법이다.

손실함수는 알고리즘이 얼마나 엉망인지를 알려준다. 그럼 작을 수록 좋겠네?

하지만 최솟값은 알지 못한다. (global minima를 알지 못하여 local minima를 찾아간다.)

cost function = 손실함수 뭐 비슷하다.

로지스틱 함수처럼 [0, 1]로 결과가 나오는 경우에 사용할 수 있다. 다음과 같이 함수를 정의했다. target=1일 때에는 로그를 취해서 -를 붙여준 손실값을, target=0일 때에는 target=1인 것처럼 변환하여 손실값을 구해준다.

말로하면 엄청 어려워보이지만 사진으로 보면 아 뭐야 싶다

이 손실함수를 로지스틱 손실함수라고 부른다 = 이진 크로스엔트로피 함수

다중 분류에서는 크로스엔트로피 함수라고 부른다. / 회귀에서는 mse사용

에포크와 과대/과소적합

에포크 횟수가 적으면 모델이 훈련 세트를 덜 학습한다. 산을 다 내려오지 못하고 훈련을 마친다.

반대로 횟수가 많으면 모델이 훈련 세트를 너무 많이 학습해서 과대적합이다.

그러면 과대적합이 되기 전에 훈련을 종료 = 조기종료 시키면 된다.

확인문제

1. 4

2. 3

실습 코드

'AI > AID' 카테고리의 다른 글

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 06 (0) | 2024.11.07 |

|---|---|

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 05 (1) | 2024.11.05 |

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 03 (7) | 2024.10.04 |

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 02 (2) | 2024.10.04 |

| [혼공 머신] 혼자 공부하는 머신러닝 정리하기 - Chapter 01 (7) | 2024.09.27 |